La inteligencia artificial (IA) continúa su impresionante evolución, presentando constantes innovaciones que desafían los límites de lo posible. En este panorama cambiante, el modelo Notux 8x7B-v1 emerge como un hito significativo, marcando un nuevo estándar en el campo de los modelos de IA, específicamente en los denominados «Mixture of Experts» (MoE). Desarrollado por Argilla y basado en los esfuerzos previos de MistralAI, este modelo representa una síntesis de los últimos avances en técnicas de optimización de preferencias y refinamiento de modelos preentrenados.

El Notux 8x7B-v1 es una versión afinada del modelo Mixtral-8x7B-Instruct-v0.1, optimizado mediante la técnica de Optimización de Preferencias Directas (DPO, por sus siglas en inglés) utilizando el conjunto de datos argilla/ultrafeedback-binarized-preferences-cleaned. Esta metodología avanzada de afinamiento permite que el modelo no solo mejore su rendimiento en comparación con su predecesor, sino que también se destaque en el liderazgo de los modelos MoE en el Open LLM Leaderboard de Hugging Face, reconocido punto de referencia en la comunidad de IA.

El impacto de Notux 8x7B-v1 en el campo de la inteligencia artificial es multifacético. No solo demuestra mejoras en la eficiencia y precisión del procesamiento del lenguaje natural en múltiples idiomas, sino que también ejemplifica el potencial de las técnicas de afinamiento de modelos preentrenados. Su diseño es un claro indicativo de la tendencia hacia una personalización más profunda y específica en el desarrollo de modelos de IA, una dirección que seguramente influirá en futuras investigaciones y aplicaciones prácticas.

Contenido

Notux 8x7B-v1: Un Gigante en el Mundo de la IA

El modelo Notux 8x7B-v1 representa un avance significativo en el mundo de la inteligencia artificial, especialmente en lo que respecta a los modelos generativos preentrenados y los sistemas de Mixture of Experts (MoE). Este modelo no es solo una mejora incremental sobre sus predecesores, sino que se ha establecido como un gigante en su campo, gracias a una serie de características y mejoras específicas.

Características Destacadas

- Modelo de IA de Última Generación: El Notux 8x7B-v1 es un modelo generativo Sparse Mixture of Experts, lo que significa que utiliza un enfoque de «expertos dispersos» para procesar y generar lenguaje. Esta metodología permite que el modelo se especialice en diferentes aspectos del lenguaje y maneje eficientemente una amplia gama de tareas de procesamiento del lenguaje natural.

- Multilingüe y Versátil: El modelo está capacitado para comprender y generar texto en varios idiomas, incluidos inglés, español, italiano, alemán y francés. Esta capacidad multilingüe lo hace extremadamente versátil y aplicable en un contexto global.

- Licencia Abierta: Al estar bajo la licencia MIT, el Notux 8x7B-v1 se posiciona favorablemente en la comunidad de desarrolladores, permitiendo su uso y modificación con una flexibilidad considerable.

Mejoras Técnicas

- Basado en Mixtral-8x7B-Instruct-v0.1: El Notux 8x7B-v1 se afinó a partir del modelo Mixtral-8x7B-Instruct-v0.1, heredando y mejorando sus capacidades. Esto incluye una mayor eficiencia en el procesamiento del lenguaje y una mejor adaptabilidad a diferentes contextos y requerimientos de los usuarios.

- Optimización con DPO: La técnica de Optimización de Preferencias Directas (DPO) utilizada para afinar el modelo le permite adaptarse más precisamente a las preferencias y necesidades específicas de los usuarios. Esto lo hace particularmente efectivo en tareas que requieren una comprensión y generación de lenguaje altamente contextualizada.

- Rendimiento Superior: En comparación con su modelo base y otros competidores en el mercado, el Notux 8x7B-v1 ha demostrado un rendimiento superior en varios benchmarks, posicionándose como líder en el Open LLM Leaderboard de Hugging Face.

Estas características y mejoras no solo hacen del Notux 8x7B-v1 un modelo destacado en el campo de la IA, sino que también abren nuevas posibilidades en cuanto a aplicaciones prácticas y futuras investigaciones.

El Origen: Evolución desde MistralAI

La génesis del modelo Notux 8x7B-v1 se encuentra en los esfuerzos previos de MistralAI, una organización reconocida por sus avances significativos en el campo de la inteligencia artificial. El Notux 8x7B-v1 no solo es un producto de innovación continua, sino también un testimonio del progreso acumulativo en la IA.

La Base: Mixtral-8x7B-Instruct-v0.1

- MistralAI y Su Impacto: MistralAI ha sido una figura clave en el desarrollo de modelos de IA avanzados. Su modelo Mixtral-8x7B-Instruct-v0.1 estableció un alto estándar en términos de capacidad de procesamiento del lenguaje y adaptabilidad a distintas tareas de IA.

- Transición Hacia Notux 8x7B-v1: La transición del modelo Mixtral-8x7B-Instruct-v0.1 al Notux 8x7B-v1 es un ejemplo de cómo la optimización y el ajuste fino pueden transformar un modelo ya eficaz en algo aún más potente. Esta evolución demuestra la importancia de la mejora continua y la adaptación en el campo de la IA.

Innovaciones y Mejoras

- Enfoque en la Optimización de Preferencias: La adopción del método DPO (Optimización de Preferencias Directas) por parte del equipo de Argilla representa un avance significativo en la personalización de los modelos de IA. Esto permite que el Notux 8x7B-v1 se alinee más estrechamente con las preferencias específicas de los usuarios y las tareas que requieren un procesamiento del lenguaje más sofisticado.

- Resultados Experimentales y Feedback: El modelo Notux 8x7B-v1 es fruto de experimentación y feedback constante. La metodología adoptada por el equipo de Argilla para desarrollar y afinar este modelo destaca la importancia de un enfoque basado en datos y retroalimentación en la IA.

Legado y Futuro

- Inspiración para Futuros Modelos: La evolución del Notux 8x7B-v1 sirve como un modelo a seguir para futuros desarrollos en la IA. Muestra cómo el aprendizaje continuo, la optimización y la adaptabilidad son cruciales para el progreso en este campo dinámico.

- Potencial de Aplicación: La versatilidad y eficiencia del Notux 8x7B-v1 abren un abanico de posibilidades para su aplicación en diversas áreas, desde la mejora de asistentes virtuales hasta la creación de sistemas avanzados de procesamiento de lenguaje natural.

Este origen y evolución no solo contextualizan el lugar del Notux 8x7B-v1 en el panorama actual de la IA, sino que también subrayan el papel crucial de la innovación constante en la tecnología de inteligencia artificial.

Detalles Técnicos del Modelo Notux 8x7B-v1

El modelo Notux 8x7B-v1, como una innovación significativa en el campo de la inteligencia artificial, posee una serie de detalles técnicos que subrayan su singularidad y potencial. Estos aspectos técnicos son fundamentales para entender tanto su rendimiento superior como sus posibles aplicaciones.

Arquitectura del Modelo

- Modelo Sparse Mixture of Experts (MoE): Notux 8x7B-v1 se caracteriza por su arquitectura MoE, la cual distribuye diferentes tareas de procesamiento del lenguaje a través de un conjunto de «expertos». Cada experto se especializa en un aspecto específico del lenguaje, permitiendo un enfoque más eficiente y detallado.

- Capacidades Multilingües: Gracias a su diseño avanzado, el modelo maneja eficazmente múltiples idiomas, incluyendo inglés, español, italiano, alemán y francés. Esto se logra mediante la integración de vastos conjuntos de datos y técnicas de aprendizaje profundo, lo que permite una comprensión y generación de lenguaje natural más precisa y versátil.

Tecnologías y Herramientas Utilizadas

- Entrenamiento en Pytorch y Transformers: El modelo se entrenó utilizando Pytorch 2.1.0+cu118 y Transformers 4.36.0, herramientas de vanguardia en el campo del aprendizaje automático y el procesamiento del lenguaje natural. Estas tecnologías son fundamentales para la eficacia y la capacidad de adaptación del modelo.

- Optimización con Adam: La elección del optimizador Adam, con betas=(0.9,0.999) y un epsilon de 1e-08, juega un papel crucial en la eficiencia del entrenamiento del modelo. Adam es conocido por su eficacia en el manejo de grandes conjuntos de datos y su capacidad para ajustar la tasa de aprendizaje de manera dinámica, lo que resulta en un entrenamiento más eficiente y resultados más precisos.

Rendimiento y Eficiencia

- Optimización de Preferencias Directas (DPO): La implementación de DPO ha permitido afinar el modelo para que se alinee más estrechamente con las preferencias y necesidades específicas de los usuarios. Esto se traduce en un rendimiento superior en tareas de procesamiento de lenguaje natural.

- Resultados de Benchmarking: En términos de rendimiento, el Notux 8x7B-v1 ha superado a su predecesor y otros modelos competidores en diversas pruebas, consolidándose como líder en el Open LLM Leaderboard de Hugging Face. Estos resultados destacan la eficacia del modelo en términos de precisión y capacidad de respuesta.

El Proceso de Entrenamiento: Hardware y Datos

El proceso de entrenamiento de un modelo de inteligencia artificial como el Notux 8x7B-v1 es un aspecto crucial para entender su funcionamiento y eficiencia. Este proceso involucra tanto la selección del hardware adecuado como la elección y manejo de los datos de entrenamiento.

Hardware Utilizado

- Potente Infraestructura de Entrenamiento: Para el entrenamiento del Notux 8x7B-v1, se utilizó una Máquina Virtual (VM) equipada con 8 GPUs H100 de 80GB cada una, alojada en runpod.io. Esta configuración de hardware de alto rendimiento es esencial para manejar las demandas computacionales intensivas del entrenamiento de un modelo de IA de esta magnitud.

- Beneficios de la Configuración de GPU: Las GPUs H100 son conocidas por su alta eficiencia y capacidad para procesar grandes volúmenes de datos rápidamente. Esta capacidad es crucial para el entrenamiento de modelos de IA avanzados, permitiendo iteraciones más rápidas y una convergencia más eficiente durante el proceso de entrenamiento.

Datos de Entrenamiento

- Uso de Argilla UltraFeedback: El modelo fue entrenado utilizando una iteración del conjunto de datos de Argilla UltraFeedback denominado argilla/ultrafeedback-binarized-preferences-cleaned. Este conjunto de datos es fundamental para el proceso de afinamiento del modelo, ya que proporciona una rica fuente de información sobre preferencias y respuestas del usuario.

- Importancia de la Calidad del Dataset: La calidad y relevancia del conjunto de datos son esenciales para el éxito del modelo. En este caso, el uso de un dataset binarizado y limpiado asegura que el modelo se entrene con información de alta calidad, lo que contribuye a su precisión y eficacia en tareas de procesamiento del lenguaje natural.

El proceso de entrenamiento del Notux 8x7B-v1, desde la selección del hardware hasta la elección del conjunto de datos, es un testimonio del meticuloso enfoque adoptado por Argilla. Este enfoque no solo garantiza el alto rendimiento del modelo, sino que también establece un estándar para el entrenamiento de futuros modelos de IA.

Optimización y Resultados de Entrenamiento

El proceso de optimización y los resultados del entrenamiento son aspectos fundamentales para comprender la eficacia del modelo Notux 8x7B-v1. Estos detalles no solo revelan el rigor técnico detrás del modelo, sino que también proporcionan una visión clara de su rendimiento y potencial.

Proceso de Optimización

- Hiperparámetros de Entrenamiento: Durante el entrenamiento del Notux 8x7B-v1, se emplearon hiperparámetros específicos para maximizar su eficiencia. Estos incluyen una tasa de aprendizaje de 5e-07, un tamaño de lote de entrenamiento de 8 y un tamaño de lote de evaluación de 4. Además, se utilizó una configuración de multi-GPU con un total de 8 dispositivos, lo que permitió un tamaño de lote de entrenamiento total de 64 y un tamaño de lote de evaluación total de 32.

- Uso del Optimizador Adam: El optimizador Adam, conocido por su eficiencia en el manejo de grandes conjuntos de datos, fue una elección crucial en el proceso de entrenamiento. Sus parámetros, como betas=(0.9,0.999) y un epsilon de 1e-08, fueron fundamentales para ajustar la tasa de aprendizaje de manera dinámica y lograr un entrenamiento más efectivo.

- Programación del Learning Rate y Época de Entrenamiento: La estrategia de programación lineal para el learning rate y el enfoque de una única época de entrenamiento, aunque breve, fue suficiente para alcanzar resultados significativos, demostrando la eficiencia del modelo y la efectividad de los hiperparámetros elegidos.

Resultados del Entrenamiento

- Eficiencia y Eficacia: Los resultados del entrenamiento del Notux 8x7B-v1 muestran una notable eficiencia y eficacia. Con pérdidas de entrenamiento y validación que reflejan una alta precisión y una baja tasa de error, el modelo demostró su capacidad para aprender y adaptarse rápidamente a las tareas de procesamiento del lenguaje natural.

- Rendimiento en Validación y Feedback: Los resultados en términos de recompensas elegidas/rechazadas y precisión/márgenes durante la validación indican que el modelo no solo es capaz de generar respuestas precisas, sino también de diferenciar efectivamente entre respuestas de alta y baja calidad.

Comparativa de Rendimiento: Notux 8x7B-v1 vs Mixtral-8x7B-Instruct-v0.1

Una parte integral de la evaluación de cualquier nuevo modelo de IA es la comparación de su rendimiento con modelos anteriores o competidores. En el caso del Notux 8x7B-v1, su comparación directa con el Mixtral-8x7B-Instruct-v0.1 proporciona una perspectiva clara de su avance y superioridad en varios aspectos.

Superando al Predecesor

- Mejoras en Eficiencia y Precisión: Notux 8x7B-v1 no solo ha heredado las capacidades del Mixtral-8x7B-Instruct-v0.1, sino que también las ha mejorado significativamente. Esto se refleja en una mayor eficiencia en el procesamiento del lenguaje y una precisión mejorada en tareas de IA variadas.

- Optimización con DPO: La implementación de la Optimización de Preferencias Directas (DPO) ha sido un factor clave en el salto cualitativo del Notux 8x7B-v1 respecto a su predecesor. Esta técnica ha permitido una afinación más precisa del modelo según las necesidades y preferencias de los usuarios.

Liderazgo en el Open LLM Leaderboard

- Posicionamiento en el Liderazgo: A partir del 26 de diciembre de 2023, el Notux 8x7B-v1 se posicionó como el modelo líder en el Open LLM Leaderboard de Hugging Face, superando a otros modelos en términos de rendimiento y eficacia. Esto no solo demuestra su superioridad técnica, sino también su relevancia y aplicabilidad en el mundo real.

Impacto en el Campo de la IA

- Estableciendo Nuevos Estándares: La comparación de rendimiento entre el Notux 8x7B-v1 y el Mixtral-8x7B-Instruct-v0.1 no solo resalta las mejoras técnicas, sino que también establece nuevos estándares para futuros desarrollos en modelos de IA. El Notux 8x7B-v1 sirve como un ejemplo claro de cómo la innovación continua puede llevar a avances significativos en la tecnología.

Esta comparativa de rendimiento no solo valida la superioridad del Notux 8x7B-v1 sobre su predecesor, sino que también ilustra la importancia de la innovación y la mejora continua en la evolución de la IA.

Impacto en la Comunidad de IA y Futuras Investigaciones

El lanzamiento del modelo Notux 8x7B-v1 no solo representa un hito técnico, sino que también tiene un impacto significativo en la comunidad de inteligencia artificial y establece nuevas direcciones para futuras investigaciones.

Influencia en la Comunidad de IA

- Estableciendo Nuevos Paradigmas: El Notux 8x7B-v1 ha demostrado cómo la optimización de preferencias y las metodologías de afinamiento pueden mejorar sustancialmente el rendimiento de los modelos de IA. Esto incentiva a la comunidad científica y tecnológica a explorar y adoptar enfoques similares en el desarrollo de futuros modelos.

- Colaboración y Compartición Abierta: Dado que el modelo se comparte bajo la licencia MIT, promueve un espíritu de colaboración y acceso abierto en la comunidad. Esta disposición facilita que investigadores y desarrolladores de todo el mundo puedan experimentar, modificar y mejorar el modelo, acelerando así el avance de la IA.

Impulso para Futuras Investigaciones

- Ampliación de Horizontes en IA: El éxito del Notux 8x7B-v1 abre nuevas líneas de investigación en el campo de la IA, especialmente en áreas como el procesamiento de lenguaje natural multilingüe y la personalización de modelos de IA a gran escala.

- Inspiración para la Innovación: Este modelo sirve como inspiración para futuras investigaciones, demostrando que la mejora continua y la aplicación de técnicas innovadoras pueden conducir a avances significativos en la tecnología de IA.

- Redefinición de Expectativas y Capacidades: El Notux 8x7B-v1 redefinió lo que es posible en términos de rendimiento y eficiencia en modelos de IA, lo que estimula a la comunidad a elevar sus expectativas y explorar aún más el potencial de la IA.

El impacto del modelo Notux 8x7B-v1 en la comunidad de IA y su influencia en futuras investigaciones subrayan su importancia no solo como un logro técnico, sino también como un catalizador de innovación y colaboración en el campo de la inteligencia artificial.

Resumen

El modelo Notux 8x7B-v1 marca un hito en el campo de la inteligencia artificial, destacándose por su avanzada arquitectura de Sparse Mixture of Experts y su enfoque en la optimización de preferencias. Desarrollado por Argilla y basado en el modelo preexistente Mixtral-8x7B-Instruct-v0.1, este modelo ha establecido nuevos estándares en términos de eficiencia, precisión y adaptabilidad.

Puntos Clave

- Superioridad Técnica: La adopción de técnicas de afinamiento como la Optimización de Preferencias Directas (DPO) y el uso de un conjunto de datos especializados han permitido que el Notux 8x7B-v1 supere a su predecesor en rendimiento, consolidándose como un líder en el Open LLM Leaderboard de Hugging Face.

- Impacto Comunitario y Científico: La disponibilidad del modelo bajo la licencia MIT fomenta un entorno colaborativo, permitiendo que investigadores y desarrolladores de todo el mundo puedan contribuir a su mejora y adaptación. Este enfoque abierto y colaborativo es fundamental para el avance continuo en el campo de la IA.

- Futuras Investigaciones y Aplicaciones: El Notux 8x7B-v1 no solo es un modelo de IA de alta eficiencia, sino que también sirve como un punto de referencia para futuras investigaciones y desarrollos en la tecnología de IA, abriendo caminos hacia aplicaciones más avanzadas y personalizadas.

En conclusión, el Notux 8x7B-v1 representa un avance significativo en el mundo de la inteligencia artificial, demostrando la importancia de la innovación continua, la colaboración y la adaptabilidad en el desarrollo de tecnologías de IA. Este modelo no solo mejora lo que ya existía, sino que también abre nuevas posibilidades para el futuro de la inteligencia artificial.

Fuente: https://huggingface.co/argilla/notux-8x7b-v1

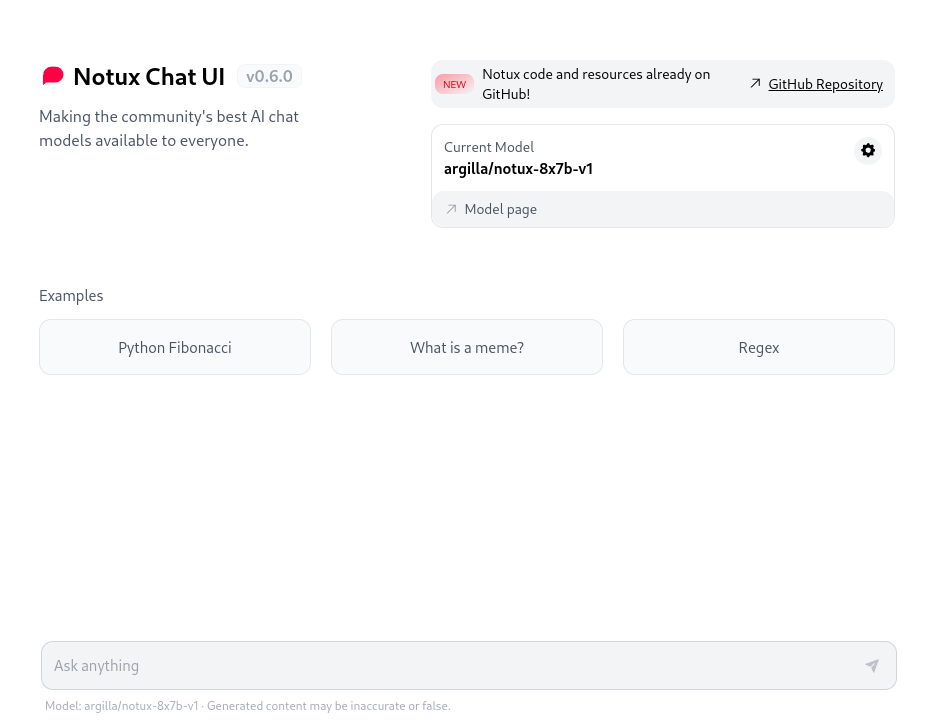

Probar modelo: https://huggingface.co/spaces/argilla/notux-chat-ui

Deja una respuesta